Creo que no había usado aún la palabra ludita en todos los envíos que llevo de esta newsletter. De los luditas hablaré bastante en futuros envíos, pero para entender el resto de este texto creo que es necesario hacer una pequeña definición.

No entraré en el origen de la palabra, solo en su uso actual. Se considera ludita a la persona que está en contra de un cierto avance tecnológico que repercute en su trabajo de forma negativa. Dentro del contexto de la inteligencia artificial, se suele usar la palabra para referirse a aquellas personas que están en contra de la IA porque creen que puede reemplazar su puesto de trabajo (ahora o en un futuro).

También se autoincluyen en este grupo aquellos que simplemente están en contra de que la IA pueda reemplazar cualquier trabajo humano (no necesariamente el suyo). Es de esta amplia categoría de personas de las que quiero hablar hoy.

Existe mucha hipocresía en el uso de la IA. Hay gente que dice estar en contra de ella pero la usa a nivel personal. Profesores redactando ejercicios con ChatGPT que se quejan de alumnos que usan ChatGPT para hacerlos. Gente que usa la IA a escondidas haciendo pasar el trabajo de la IA por propio, bajo el entendimiento (correcto en gran medida) de que se trata de una herramienta más. Esto último era la base del primer anuncio de Jasper (una herramienta para el uso de IA para la creación de contenidos) .

Pero de este anuncio hace ya un año. Han pasado muchas cosas. Han aparecido muchos modelos tras GPT, y muchas herramientas similares a Jasper, incluso aplicaciones de nicho para todo tipo de formatos (texto, imagen, vídeo, audio…).

Durante este tiempo se han podido ver tanto las excelencias de la IA de generación, como también se han podido descubrir sus defectos. De ahí que esté surgiendo cierta tendencia que busca lo artesanal, lo realizado por un humano. Cierta tendencia a hacer las cosas como se hacían antes (el año pasado :-s).

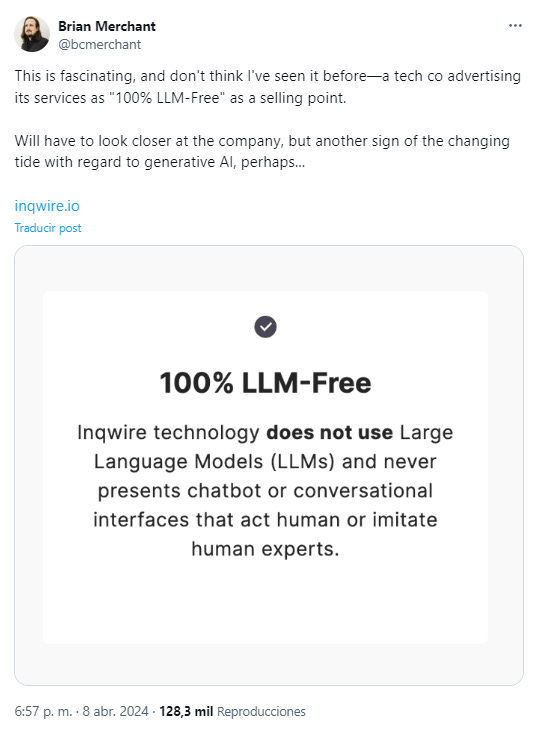

Ya empieza a considerarse “sin uso de LLM“ como un elemento de valor.

El problema aquí es saber porqué quieres algo hecho 100% por un humano en el que no intervenga la IA para nada. Es el momento de preguntarse si estamos en contra de la IA por principio moral o si estamos en contra porque todavía no es la IA que nos habían prometido.

Si lo que pasa es que has usado la IA como herramienta pero no te ha dado los resultados que esperabas, ya sea porque no has sabido promptear con ella o bien porque simplemente aún no esté preparada para lo que le pides, no eres ludita.

Tampoco eres ludita si el hecho de no disponer de una IA de generación que te sea útil te haya hecho estar en contra de este tipo de herramientas.

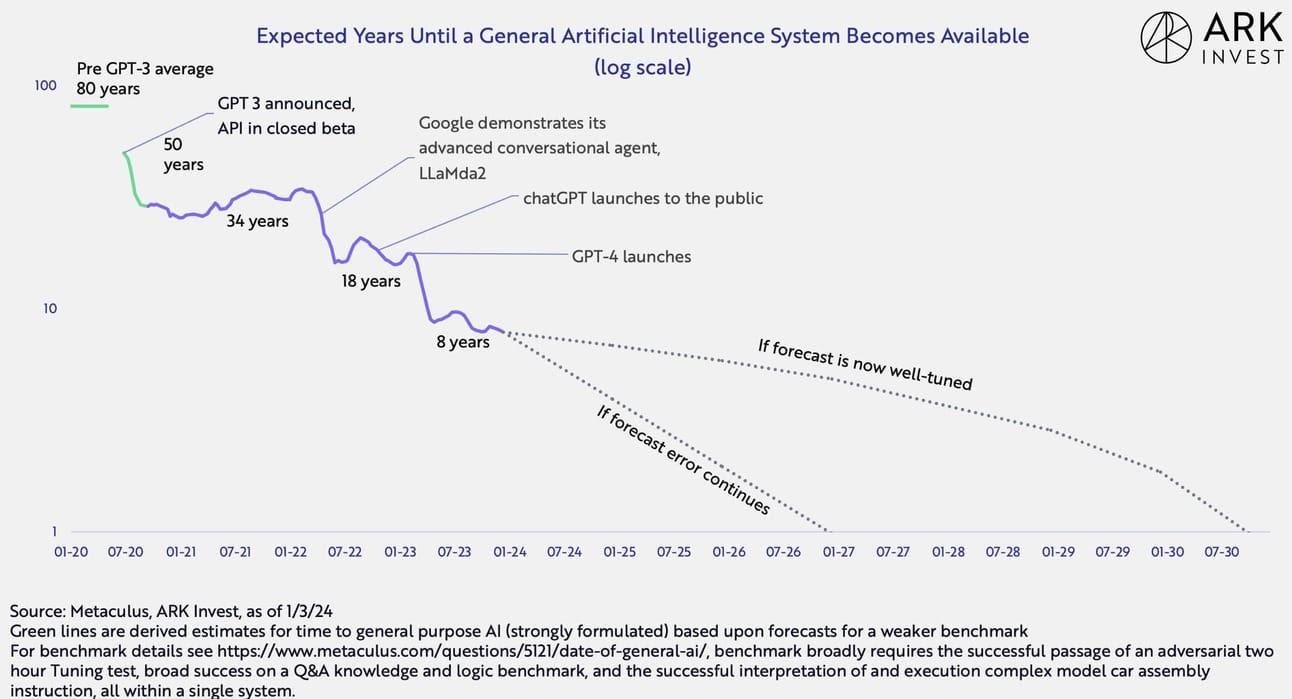

Lo que pasa en estos casos es que sufres un simple caso de impaciencia. Provocada seguramente por las declaraciones de los Sam Altman y Elon Musk de turno proclamando la aparición inminente de la AGI (la IA general).

Tú lo que quieres es una herramienta que no te genere dudas, que te facilite el trabajo y que además sea sencilla de usar. Lo que quieres es algo que sea usable (de usabilidad), útil y que no alucine.

El factor más difícil de resolver a día de hoy es seguramente el de las alucinaciones, la causa principal de que aún muchos no vean a este tipo de herramientas como algo útil.

A día de hoy hay dos técnicas principalmente para evitar en alguna medida este problema, una es el finetuning, la otra es el RAG. De ellas hablaré en próximos envíos, pero no quiero detenerme en ellas pues no son infalibles.

Quiero pararme en un tercer intento de evitar las alucinaciones. Algo que ha aparecido este mes de la mano de Pinecone (los de las bases de datos de vectores, que se suelen utilizar en la técnica del RAG) y que no es otra cosa que Luna, el primer LLM que no alucina.

Pero antes de descorchar el cava hay que aclarar también que en la actualidad casi todas sus respuestas son del tipo:

“No lo sé.“

O sea, no alucina, pero útil, lo que se dice útil, no es (todavía).

— David, David, porque lo mencionas entonces.

Pues porque han usado una técnica interesante. Algo que llaman information-free training (entrenamiento sin información). Es decir, que no han usado ningún tipo de información —o sea, cero problemas de copyright. Lo que se busca es un resultado parecido a lo que los modelos Alpha-Zero y AlphaGo Zero (de Deepmind, que ahora es de Google) lograron en su momento, modelos basados en aprendizaje automático y aprendizaje por refuerzo. Supongo que la idea de Pinecone es construir algo que pueda llegar a aprender solo a partir de conversaciones con sí mismo.

Otra cosa buena del modelo es que es open source, aunque no han liberado el código completo aún.

Insisto que el modelo ahora no es útil, da 0% de performance en casi todos los campos de interés, pero quizás sea la semilla de un algoritmo diferente, sin sesgos, sin problemas de derechos de autor, solo razonamiento puro de la máquina.

Un enfoque distinto en un mar de algoritmos de generación cada vez más amplio.

Yo, de momento, voy a tener un poco de paciencia y ver como evoluciona.

Despedida y cierre

Hoy una breve reflexión sobre la impaciencia tecnológica. La semana que viene más.

La IA genera el vértigo y la fascinación de un cambio insondable, pero a la vez espanta con su ruido. Me pasa que las imágenes que veo ahora en ig generadas con ella, son todas iguales, con estilo comiquero, y echan para atrás además cuando pretenden hacer pasar por real su mundo imaginario. Sumado a la avalancha de automatización del mundo real (bancos, citas, atención al cliente...), que está deshumanizando las relaciones comerciales a pasos agigantados.